ИНФОРМАЦИОННАЯ КУЛЬТУРА. МУН Д.В., ПОПЕТА В.В. «FROM FAKE TO DEEPFAKE»: УГРОЗЫ И РИСКИ РАЗВИТИЯ И РАСПРОСТРАНЕНИЯ ТЕХНОЛОГИЙ ИСКАЖЕНИЯ РЕАЛЬНОСТИ В ГЛОБАЛЬНОМ ИНФОРМАЦИОННОМ ПРОСТРАНСТВЕ

Пример № 1 [1]. Полицией небольшого мексиканского городка Акатлан с населением чуть больше шестнадцати тысяч человек 29 августа 2018 года были задержаны два «чужих и очень подозрительных» человека. Согласно показаниям участвовавших в задержании полицейских, мужчины не совершали никакого преступления. Просто в один момент в участок посыпались звонки от разъяренных граждан, утверждавших, что они видели на улицах города членов гастролирующей по стране банды «похитителей детей».

Стражи порядка по требованию общественности доставили «гостей города» для дознания в полицейский участок. Однако жителям Акатлана этого оказалось недостаточно: стремительно собравшаяся толпа разъяренных «единомышленников» штурмом взяла охраняемое помещение, выволокла «похитителей» на улицу, избила и затем сожгла заживо их тела. Почти все участники «линчевания» снимала происходящее на мобильники, многие вели онлайн трансляцию в WhatsApp и Facebook. Мать Рикардо Флореса Мария, находясь на севере страны, получила от знакомых ссылку на в Фейсбуке, кликнув на которую, смогла наблюдать за публичной расправой над её сыном и братом в режиме реального времени [1].

Как впоследствии оказалось, казненными без суда и следствия «чужаками» оказались коренные мексиканцы, 21-летний Рикардо Флорес и его 43-летний дядя Альберто, приехавшие из соседней деревни навестить свою бабушку, всю жизнь прожившую в этом городе, и помочь ей по хозяйству. Погибшие мужчины ранее никогда не имели проблем с законом. Похороны Рикардо и Альберто Флоресов состоялись в городе на следующий день. На службу и отпевание собралась толпа тех же вчерашних зевак, цинично снимавших и транслировавших в том же режиме онлайн слезы и страдания безутешной Марии Флорес.

По данным властей штата, причиной трагедии в Акатлане стали передававшиеся пользователями мессенждера WhatsApp фейковые новости о якобы приехавшей в Мексику банде преступников, которые похищают детей на улицах городов и затем умерщвляют их для торговли внутренними органами. Был выявлен зачинщик беспорядков и четыре его основных пособника – подстрекателя – все местные жители - которые при помощи все тех же Вотсапа и Фейсбук смогли путем массированной рассылки фейка в кратчайшие сроки собрать, распалить и направить толпу. Им были предъявлены обвинения в подстрекательстве и убийстве. [1]

Недостоверные, или «фейковые» новости – это информация, которая распространяется с целью извлечения политической и финансовой выгоды, а также для увеличения читательской аудитории и цитируемости. «Вброс» недостоверных сведений, умышленное продвижение лжи или дезинформация известны с давних пор. Данный прием используется в политической борьбе с конца XIX века, в эру становления «традиционных» медиа [2] – печатных, радио, и телевизионных СМИ – под названием «газетная утка» и т.п. Однако наиболее сильное воздействие на мировые события фейк-ньюс производят в эпоху формирования новых, «горизонтальных» медиа: мессенджеров, социальных сетей, которые обладают возможностью не только моментально и адресно распространять контент, но и оперативно получать обратную связь.

Неслучайно сегодня фейк-ньюс относят к числу основных угроз мирового порядка: правительства большинства стран мира разрабатывают способы законодательной борьбы с данным явлением. Об угрозе фейковых новостей сделал свое особое заявление даже Папа Римский Франциск, сравнивая их со змеем-искусителем из Библии, «змеиные тактики которого нам необходимо разоблачать». В ряде стран, например в Малайзии, Испании, Китае, распространителям фейков грозят серьезные тюремные сроки. Жесткие законы собираются принимать в США, Индии и Евросоюзе. После «вброшенных» информационных провокаций об «истинных масштабах трагедии в «Зимней вишне» [3] Россия отреагировала на данный социокультурный феномен, оперативно разработав правовые основания санкций против изготовления и распространения общественно опасных фейков. «Распространение в СМИ, а также в информационно-телекоммуникационных сетях заведомо недостоверной общественно значимой информации под видом достоверных сообщений, которая создает угрозу жизни и (или) здоровью граждан, массового нарушения общественного порядка и (или) общественной безопасности, прекращения функционирования объектов жизнеобеспечения, транспортной или социальной инфраструктуры, наступления иных тяжких последствий» нарушителям грозит административная ответственность в виде штрафов от 30 тысяч до полутора миллионов рублей. В свою очередь, интернет-ресурсы, уличенные в распространении фейков и не принявшие срочных мер по удалению недостоверной общественно-опасной информации, подлежат блокировке по запросу Роскомнадзора [4].

Однако на сегодняшний день, с учетом специфики функционирования данного социально-технологического явления, реально остановить или хотя бы сдержать общественную фейк-угрозу не представляется возможным.

Существует как минимум три причины, затрудняющих противодействие производству и распространению фейк-новостей.

Первая причина – глобальное и неконтролируемое распространение информационных технологий среди населения планеты. По состоянию на 2019 год аудитория интернета насчитывает 4,39 миллиарда человек, что на 366 миллионов (9%) больше, чем в январе 2018 года. В социальных сетях зарегистрировано 3,48 миллиарда пользователей. По сравнению с данными на начало прошлого года этот показатель вырос на 288 миллионов (9%).

На нынешнем этапе технологического развития цивилизации, создание, владение, контроль и распространение информации перестали быть прерогативой социально-правительственных элит и подконтрольных им централизованных/вертикальных СМИ. Информационные технологии подарили человеку никогда прежде не имевшуюся возможность не только «читать, видеть и слышать», но и быть «прочитанным, увиденным и услышанным». Практически каждый человек, имеющий смартфон, доступ в интернет, аккаунт в соцсетях, приобрел возможность не только потреблять, но также генерировать, изменять, создавать, и распространять информацию в неограниченном объеме. Рядовые пользователи сети не замедлили воспользоваться предоставленной им возможностью. Информационно-цифровую вселенную захлестнул неудержимый вал видео, фото, селфи, постов, блогов, репостов и других проявлений информационной деятельности от индивидуальных пользователей сети.

На сегодняшний день Интернет предоставляет доступ к 81 триллиону изображений и 7 триллионам видеоклипов; ежедневно в Интернет загружается 28 изображений и 2,5 клипа на каждого жителя Земли. Согласно прогнозам, к 2020 году мобильное видео как самый простейший индивидуальный способ создания и потребления информации выйдет на первое место среди всех других ресурсов всемирной сети. К 2025 году прогнозируемый объем информации, создаваемой в интернете, составит 175 зеттабайт [5,6]. На фоне данных прогнозов попытки взять под контроль и управление этот процесс, инвестиции в формирование программ и технологий «реальной защиты» от фейков кажутся наивными.

Например, агентство Bloomberg недавно сообщило, что Министерство обороны США заказало программное обеспечение, которое должно выявлять фейковые новости в сообщениях сетевых изданиях, социальных сетях, аудио- и видеороликах, размещаемых в Интернете. Согласно заявленной стратегии специальная программа сможет просматривать до полумиллиона новостных сообщений и постов в социальных сетях на предмет возможного манипулирования общественным мнением и пропаганды, а операторы смогут оперативно реагировать на фейковые «вбросы». [7]. В силу масштабности проблемы, любые попытки государственных и международных структур взять под мониторинг и контроль распространение информационных потоков пока обречены на неудачу.

Вторая причина - сложность установления первичного информационного «вброса» деструктивного фейка в случае использования для передачи информации зашифрованных «мессенджеров». Если «вбросы» и распространение опасных фейков можно отследить через социальные сети (хотя Фейсбук потерпел поражение, о чем будет подробно указано далее), то в случае с чатами типа WhatsApp, где используются алгоритмы двойного шифрования и у операторов системы нет доступа к переписке пользователей, отсутствует техническая возможность мониторинга всех сообщений.

Пример № 2 [8]

Возьмем в качестве примера Индию, больше других стран пострадавшую от фейков (о бандах пресловутых похитителей детей). В основе информационного «вброса», который стремительно передавали друг другу в естественном желании поделиться важной новостью пользователи WhatsApp, лежит «вирусный» ролик, на котором двое мотоциклистов с лицами, закрытыми шлемами, похищают на улице оставленного без присмотра взрослых ребенка. Данное видео, несмотря на низкое качество изображения, стремительно распространилось среди пользователей сразу нескольких индийских штатов и стало основанием для преследования местными жителями любых приезжих, ставших заведомо подозрительными, людей. 4 июля 2018 года правительство Индии обратилось к компании, владеющей WhatsApp, с требованием выдать ключи шифрования для выявления зачинщиков и предпринять «немедленные меры» против злоупотреблений платформой. [8] Но, не смотря на ежедневные разъяснения в официальных СМИ о «фейковых вбросах» пользователи продолжали пересылать друг другу «секретную, скрываемую властями» информацию о наводнивших страну и орудующих в разных штатах бандах. WhatsApp отказался представлять «ключи» шифрования индийским властям, но, разделяя озабоченность тем, как чудовищно бесплатное приложение используется для манипуляции массами, предпринял ряд действий, направленных в первую очередь на ограничение возможностей рассылки сообщений: не более пяти адресатов в Индии и максимум двадцать адресатов по всему миру. Кроме того, в алгоритм была добавлена метка «Переадресовано» (Forwarded) для тех случаев, если сообщение было просто скопировано и переправлено далее. [8]

Анализ ролика, ставшего основой фейкового потока, показал, что это видео снято в качестве социальной рекламы общественной волонтерской организации из Пакистана, борющейся против киднеппинга и напомнающей нерадивым родителям, что за детьми в больших городах нужен постоянный присмотр. И здесь возникают главные вопросы: кому и зачем было нужно укоротить данный ролик до такой степени, чтобы подтолкнуть людей к насилию? Кто и зачем распространял этот ролик среди своих друзей, родных и знакомых? Почему реальных зачинщиков, осуществивших искажение информационно-новостного пространства, пока невозможно призвать к ответу?

Таким образом, WhatsApp стал для людей вместо средства оперативного и конфиденциального общения, каким он изначально задумывался, смесью из «испорченного телефона» и «сарафанного радио», с соответствующими тяжёлыми последствиями.

Третья, наиболее значимая причина, по которой нельзя остановить производство и распространение фейк-новостей – это их значимость для производителей, потребителей и распространителей. Фейк-ньюс нужны персонам, желающим самоактуализироваться, поднять свою значимость в глазах общественности, продемонстрировать собственную элитарность, выражающуюся в доступе с секретному, сокровенному, скрываемому и претендующему на альтернативную истинность знанию.

Любознательность – генетически заложенный во всех нас механизм выживания как вида. Новое знание – в его нормальном проявлении – вещь чрезвычайно полезная, по сути, двигающая вперед прогресс. Неслучайно во главу угла всех диссертаций ставится в первую очередь научная новизна. Поделиться с собеседником информацией, претендующий в данный момент на сенсацию – не важно, что потом она будет опровергнута и предана забвению – значит – преподнести партнеру по коммуникации свою важность и поднять свой социальный статус. И неважно, что он сиюминутный и виртуальный – для большинства представителей поколения, родившегося со смартфоном и планшетом в руках – разница между миром реальным и виртуальным напрочь отсутствует. Напротив, для «digitalnatives» виртуальный мир более понятен, они в нем лучше ориентируются, легче преуспевают, следовательно, мир лайков, хайпа и фрагов для них более важен, чем та среда, в которой и по законам которой существует их «физическая оболочка».

Следует отметить, что даже если последовало официальное опровержение, авторитет распространителя не сильно упадёт: ведь если ничего плохого не случилось. Если все же случилось где-то что-то подобное – авторитет распространителя резко возрастает: любому его следующему «вбросу» начинают доверять, его могут привлечь в качестве эксперта «вертикальные» СМИ, он может заработать денег и обрасти известностью и т.д. Таким образом, распространитель заведомых фейков практически ничего не проигрывает и в большинстве случаев оказывается в выигрыше. Каждый пользователь, вставший на этот путь, понимает, что с фейк-ньюс, как в рулетке, чтобы повезло, нужно чаще ставить на кон: искать, создавать, распространять как можно больше псевдосенсаций.

Как пишет в своей книге «Максимальный репост» Бронислав Козловский [9], «чтение, а главное – репосты новостей — это не столько способ добыть информацию, сколько возможность показать себя другим людям. То есть социальный ритуал, который можно сравнить с посещением воскресной службы в церкви. Или с покупками в дорогом магазине. Нажимая на кнопку «поделиться», вы сообщаете, что такое-то событие важно для вашей картины мира… А если вам важен отклик, то ценность фальшивых и настоящих новостей неодинаковая — и ложные выгоднее истинных…неправдоподобные новости обещают больше нового знания — то есть являются «новостью» в превосходной степени. И привлекают к себе больше внимания». [9]

Согласно исследованиям специалистов Массачусетского технологического института (опубликовано в журнале Science в 2018 году [10]), изучившим более 126 000 фейковых новостей, которые были опубликованы в Twitter за все время его существования с 2006 по 2017 год, заведомо очевидные фейк-новости распространяются в среднем в шесть раз быстрее «реальной» информации из достоверных источников. Кроме того, для фейковой новости вероятность перепоста на 70% выше. [10] При этом максимальной скоростью распространения обладают фейки на темы, связанные с политическими деятелями, «медийными» персонами, катастрофами и стихийными бедствиями. [9]

«Глубина каскадов» – важнейший параметр, непосредственно характеризующий, как далеко может распространиться новость по цепочкам репостов. И здесь «правда» также оказалась в проигрыше: «фейки» в десять раз быстрее достигали показателя в 19 перепостов, в то время как «правда» ни разу не смогла преодолеть рубеж в 10 переадресаций. [9]

Как утверждают американские когнитивные психологи Крис Белл, Чип Хит и Эмили Стенберг, гипотезу которых поддерживают российские социальные антропологи Александра Архипова и Анна Кирзюк, слухи и фейковые новости распространяются в информационной среде намного успешнее «правды» именно по причине того, что люди попросту «хотят делиться друг с другом отвратительными эмоциями, которые вызывают городские легенды и слухи» [11]. И это желание также является следствием эволюционных механизмов, запрограммировавших нас предупреждать соплеменников об опасности [11].

Именно люди, а не роботы (боты), определяют скорость и направления распространение фейковых новостей в информационной среде. При этом следует особо отметить, что активнее всего «ретвитят» фейки не «авторитетные» блогеры и «звёзды инстаграма», имеющие миллионы подписчиков, а непопулярные пользователи мессенджеров и соцсетей, испытывающие острую потребность в повышении своего социально-виртуального статуса.

Вернемся к примеру № 2 (к истории с видеомемом про похитителей детей): в исходном действии есть один безусловный провокатор – пользователь всемирной сети, который произвел намеренное искажение первичного «позитивного» ролика, обрезав концовку «хеппи-энда» с возвращением ребенка; человек, превративший исходное благое дело в пандемию насилия с многочисленными жертвами и пострадавшими по всей планете. Человек, в силу сложности современной организации информационной среды, пока еще не найденный. Все остальное сделали не усилия отдельных злоумышленников, а армия виртуальных аутсайдеров - рядовых пользователей сети, желающих «приподнять» свой авторитет на распространении фейков.

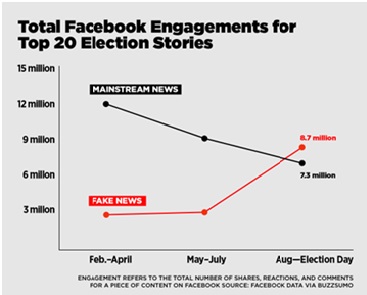

Долгое время администрация Фейсбук пыталась уйти от ответственности за контент, утверждая, что является «всего лишь технологической компанией», однако, после ряда официальных обвинений со стороны правоохранительных органов США (график 1), Цукерберг и его команда публично пообещали с 2017 года проверять подлинность выкладываемых на страницах пользователей новостей и пресекать её стихийное распространение.

График 1. Популярность «фейковых» новостей в Facebook резко выросла в течение трёх месяцев перед президентскими выборами в США 2016 года. Инфографика: BuzzFeed [13].

При этом разработчики Facebook решили не заниматься наймом платных экспертов, а опираться на ресурсы добровольцев (волонтеров), которые были готовы на безвозмездной основе определять фактическую достоверность новостей и сообщать администраторам социальной сети о недостоверной информации, содержащейся в постах. Такие посты не удалялись, а помечались специальной отметкой «спорные» («disputed»). В марте 2017 года социальная сеть начала помечать отдельные новостные истории на английском, квалифицированные волонтёрами как «фейк», специальной предупреждающей плашкой — красный восклицательный знак в треугольнике и рядом метка «disputed». Но, начиная с момента, как сообщение помечалось как «disputed», количество его просмотров и репостов многократно возрастало. Любые другие попытки на административном уровне бороться с фейками в сети порождали обратный эффект у её пользователей. Согласно независимым исследованиям, число репостов фальшивых новостей не только в Facebook, но и в других глобальных социальных сетях, по–прежнему многократно превышает число репостов добросовестных сообщений [14].

«Deepfake» технологии

Пример № 3. В декабре 2017 года сотрудники исследовательского центра NVIDIA – одного из пионеров освоения возможностей искусственного интеллекта – опубликовали на страницах своего сайта [15] статью, в которой продемонстрировали, как можно при помощи GAN - генеративно-состязательных нейросетей - полностью видоизменять исходное цифровое фото, превратив исходные зимние пейзажи в летние. В отличие от «банального» фотошопа, подделку которого человек может распознать невооруженным взглядом, разработанный в NVIDIA алгоритм «глубокого» нейросетевого машинного обучения фактически позволял создавать новую цифровую реальность. На продемонстрированных картинках, созданных при помощи технологии «глубинного обучения» (англ. Deeplearning), даже эксперты не смогли опознать подделку.

Неделю спустя на популярном социальном новостном сайте Reddit появились ссылки на порнографическое видео, на котором одна из самых известных и высокооплачиваемых голливудских актрис Галь Гадот вступает в половую связь со своим «сводным братом» [16, 17]. Автор оказавшегося поразительно достоверным фейкового видео, скрывающийся под ником Deepfakes, моментально стал чрезвычайно популярен. В последовавших за скандальной публикацией многочисленных интервью Deepfakes не только рассказал о себе, но и раскрыл общественности, как он создал свое «творение». Человек, который скрывается под данным ником – рядовой, ничем не выделяющийся программист, который признался, что использовал идеи и алгоритмы NVIDIA для того, чтобы просто воплотить свои эротические фантазии. Понятное дело, что Галь Гадот, будучи одних самых красивых и успешных женщин мира, не только никогда не снималась в «домашнем порно» у Deepfakes, но даже не была уведомлена последним о том, что стала «главной героиней» его «кино для взрослых». Программист-эротоман для создания своего «шедевра» воспользовался обычным порнофильмом, в котором на тело неизвестной порноактрисы наложил изображения лица Гадот, позаимствованные из открытых источников: многочисленных фото и видеоматериалов из Гугла и YouTube. Deepfakes пояснил, что созданием таких роликов может заниматься каждый, кто умеет пользоваться интернетом и понимает принципы работы генеративно - состязательных нейросетей. Он также назвал программное обеспечение (которое бесплатно и находится в открытом доступе), использовавшееся для создания нового жанра в порноиндустрии, названного в последствии в его честь «Дипфейк» (англ. deep ‒ глубокий, и fake ‒ подделка).

Менее чем через месяц создание дипфейковых порновидеороликов со «звездами» превратилось в мощную индустрию. Ролики с любыми исходными «лицами» стали делать быстро, дешево, на заказ. И хотя юристы призывают «оскорблённых звезд» подавать на новоявленных «порнорежиссеров» в суд за незаконную обработку персональных данных, «звезды», памятуя об известном «Эффекте Стрейзанд» [18], не торопятся выступать с официальными опровержениями, дабы не привлекать в данном контексте лишнего внимания к своим персонам со стороны пользователей всемирной сети.

Учитывая тот факт, что мобильное видео выходит на первое место как самый простой способ потребления информации, можно прогнозировать, что в скором времени увеличатся масштабы несанкционированного использования видео в сочетании с бесплатными сетевыми возможностями искусственного интеллекта.

Пример № 4.

Летом 2018 года рекордсменом по просмотрам на YouTube стало видеообращение, на котором бывший президент США Барак Обама публично оскорбляет действующего президента США Дональда Трампа. [20] Мир буквально взорвался от такой горячей новости. Видео было настолько достоверным, что поначалу никто не поверил, что оно является подделкой. Дипфейк-подделкой. Авторами провокационного ролика выступили американский комик и режиссер Джордан Пил и новостная интернет-медиа компания BuzzFeed. Дипфейк-видео, едва не ставшее поводом для «гражданской войны» между сторонниками республиканцев и демократов, было создано Пилом при помощи графического редактора Adobe After Effects и простой бесплатной программы Fakeapp, выложенной в открытом доступе на вышеупомянутом сайте Reddit. По словам Пила, главная цель, которую он, как режиссер, преследовал при создании своего «фильма», благородна: предупредить людей о том, что «настали опасные времена. В будущем мы должны быть более бдительными в вопросе, чему верить в сети. Это время, когда мы должны полагаться на авторитетные новостные источники, которым стоит доверять», — заключил Пил в конце своего скандального видеоролика устами Обамы [19] .

В непременно следующих за подобными эпизодами интервью журналистам Джордан Пил также поведал следующее: «Я знал, что это возможно, но не был уверен, действительно ли это сработает. Когда оно сработало, я подумал: «Это безумие! Посмотрите на это! Знаете, пока это еще достаточно сложно, но это гораздо легче, чем должно быть» [21].

С учетом количества и качества исходного цифрового материала, хранящегося во всемирной сети и доступного каждому, любой рядовой пользователь соцсетей, имевший ранее неосторожность выложить свои селфи и/или видео на всеобщее обозрение, рискует стать жертвой не просто розыгрыша, но и серьезной провокации или мошенничества.

Всемирные новостные ленты начали наполняться описаниями случаев подделки голосов директоров и СЕО, по устному указанию которых сотрудники переводили деньги мошенникам; «дипфейковых видео» со звездами экрана, призывающих перейти по ссылке и получить приз, и так далее.

Наибольшую опасность представляют дипфейки, которые могут использоваться при ведении информационных войн. Профессор Калифорнийского университета в Лос-Анджелесе Джон Вильясенор утверждает, что «технология deepfake станет мощнейшим инструментом в руках тех, кто захочет дезинформировать массы и напрямую влиять на политический процесс». [22] В свою очередь, американские военные считают, что самой перспективной разработкой являются редактирование и вбросы противникам поддельных спутниковых фото и видео, которые смогут их быстро дезориентировать и повергнуть мир в полный хаос [22].

В интернете уже несколько раз появлялись «пробные» видеоролики анонимных «энтузиастов», на которых руководители двух ядерных супердержав [23] сообщают о планах глобальных вооруженных нападений. Многим зрителям хватило ума отнестись к данным видео как к провокационным розыгрышам и не распространять панику в сети.

Однако нейросетевые технологии машинного обучения стремительно совершенствуются, на основании чего можно сделать вывод, что создание абсолютно достоверных «дипфейк-видео», которые будет невозможно, подвергнув экспертизе, отличить от реально снятых кадров, не «за горами». Если верить прогнозу одного из пионеров всемирной индустрии дипфейк-видео, профессора Хао Ли, «счет идет на месяцы, а не на годы. А это значит, что правдоподобные дипфейки, неотличимые от реальности, появятся во время предвыборной кампании в США — и, вполне возможно, изменят ее ход» [24]. В недавнем интервью CNBC Хао Ли отметил, что «такие дипфейки смогут создавать обычные пользователи без особой технической подготовки или уникального оборудования, и у нас есть лишь от шести до 12 месяцев, чтобы научиться распознавать подделки» [25].

Было бы неверно утверждать, что проблеме противодействия дипфейкам не уделяется должного внимания со стороны правительств, корпораций и частных лиц. Но, к сожалению, как это постоянно происходит в истории, сначала люди изобретают технологию, и лишь потом задумываются, как себя обезопасить от нее. Средства безопасности и защиты человека от достижений технического прогресса всегда сильно запаздывают в погоне за технологическим прогрессом. Сначала люди освоили огонь: и лишь тысячелетия спустя додумались изобрести огнетушитель и стали организовывать профессиональные пожарные команды; люди начали производить автомобили, разгоняющиеся до ста и более километров в час, и лишь десятилетия спустя изобрели трехточечный ремень безопасности [26]; люди научились извлекать энергию из деления ядер урана, но до сих пор так и не научились эту энергию контролировать. А к чему могут привести «шалости и игры» дилетантов с неизведанными пока возможностями искусственного интеллекта – даже страшно себе представить…

Пример № 5.

Не случайно стрелки знаменитых «Часов Судного дня» (англ. Dooms day Clock– проект, начатый в 1947 году в Чикаго учеными, создавшими первый в мире атомный реактор и атомную бомбу) 23 января 2020 года были передвинуты в самое близкое к полуночи положение за всю их историю. [27] Экспертная комиссия по переводу «Часов Судного дня», в составе которой 18 Нобелевских лауреатов, обосновывая свое решение, заключает, что сегодня мировые лидеры все менее способны противостоять все более вероятным угрозам ядерной войны, в том числе из-за нарастающих информационных войн в киберпространстве, роста числа фейковых новостей и спланированных кампаний по дезинформации в интернете.

«Наша близость к катастрофе сейчас выражается в секундах — не в часах и даже не в минутах… Мы сейчас сталкиваемся с настоящей чрезвычайной ситуацией — абсолютно неприемлемым состоянием дел в мире, которое не оставляет возможности для ошибок или задержек [с исправлением положения]» [28], утверждает исполнительный директор издания Bulletin of the Atomic Scientists Рэйчел Бронсон.

Вместо заключения

Испокон веков владеющие знанием люди чрезвычайно осторожно относились к идее неограниченного распространения информации. Многие века доступ к информации и знаниям существовал лишь для избранных, его хранили в тайне, оберегали от доступа к нему нежелательных лиц. В ряде случаев информацию даже намеренно уничтожали: чтобы оно не стало достоянием неблагонадежных лиц, способных развязать войну, посеять раздоры или узурпировать власть.

Но сегодня неуправляемое распространение недостоверной и непроверяемой информации начинает подрывать сами фундаментальные основы существования общества: взаимное доверие, доверие к государственным институтам, репутацию и авторитеты, презумпцию невиновности etc.

Конечно, некоторые страны оперативно реагируют на информационные угрозы. Например, в Китае уже приняли закон, запрещающий с 1 января 2020 года публиковать фейковые новости и вводящие в заблуждение «дипфейковые» видео, созданные с помощью искусственного интеллекта. За публикацию вводящих в заблуждение роликов предусмотрена уголовная ответственность [29].

Однако в настоящее время скорость распространения информации на порядок выше, чем оперативность реагирования на нее в виде проведения проверки, экспертизы и при необходимости создания соответствующего опровержения (с учетом того, что алгоритмы экспертизы дипфейков ещё предстоит разработать и внедрить). Поэтому кого, как и за что будут судить – вопрос весьма дискуссионный.

Впрочем, есть и другой путь. По большому счёту, люди уже порядком устали от «фейковых новостей». Так, согласно результатам социологического опроса, проведенного в США авторитетным Pew Research Center, 68% процентов американцев считают, что «фальшивая» информация влияет на доверие сограждан к государству, а 54% уверены, что фейки полностью разрушают доверие между людьми. При этом более половины опрошенных считают «фейкньюс» главной проблемой в современном мире [30].

И пока не началось внедрение тотальной государственной информационной цензуры с целью «защиты нас от нас самих», выход есть только один. Фейки как опасный социальный феномен исчезнут только тогда, когда в сознании большинства людей перестанут быть занятием социально поощряемым.

Поэтому авторы статьи убеждены, что решение проблемы недостоверной информации в эпоху «горизонтальных медиа» также должно быть «горизонтальным». То есть идти не «сверху - вниз», через трансляцию рекомендаций от правительств, элит и «официальных авторитетов», а «снизу - вверх», через постижение каждым «рядовым» пользователем «информационной вселенной» этических основ информационной культуры личности [31], ведущих к осознанию своей неизбежной персональной ответственности за каждое произведенное действие во всемирной сети и пониманием того, что одном нажатием «кнопки репост» можно не только развязать ядерную войну, но и её предотвратить.

Список источников

- 1. Мартинес М. Осторожно, фейк: как в Мексике сожгли двух мужчин из-за слухов в WhatsApp [Электронный ресурс] / М. Мартинес. –https://www.bbc.com/russian/features-46180341

- 2. Becker B., Wehner J. Electronic Net works and Civil Society // SUNY Press. – 2001. –P. 81— ISBN 978-0-79145-016-1

- 3. Скойбеда У. 400 фейков кемеровского пожара: Почему люди так легко поверили в большую ложь после трагедии в ТРЦ «Зимняя вишня» [Электронный ресурс] / У. Скойбеда // Комсомольской правде.- 2018 г. - от 02.04. - https://www.kp.ru/daily/26813/3849638/

- 4. Федеральный закон от 18.03.2019 № 31-ФЗ "О внесении изменений в статью 15-3 Федерального закона "Об информации, информационных технологиях и о защите информации" [Электронный ресурс]. – http://publication.pravo.gov.ru/Document/View/0001201903180031

- 5. Tom Coughlin. 175 Zettabytes By 2025 [Recurso electrónico]: Forbes. 2018 Nov 27. / Tom Coughlin. –https://www.forbes.com/sites/tomcoughlin/2018/11/27/175-zettabytes-by-2025/#b5fe21054597

- 6. Прогноз роста объема мировых данных по годам [Электронный ресурс]. – seagate.com

- 7. Филипенок А. В Пентагоне заказали программу для борьбы с фейковыми новостями [Электронный ресурс] / А. Филипенок // RBC. – https://www.rbc.ru/politics/01/09/2019/5d6ae9a79a79475cc886b53c

- 8. Shadab Nazmi, Dhruv Nenwani, Gagan Narhe. Social media rumours in India: counting the dead [Recurso electrónico]: BBC New. 2018 November 13 / Shadab Nazmi, Dhruv Nenwani, Gagan Narhe.– https://www.bbc.co.uk/news/resources/idt-e5043092-f7f0-42e9-9848-5274ac896e6d

- 9. Козловский Б. Максимальный репост: как соцсети заставляют нас верить фейковым новостям / Б. Козловский. – Москва: Альпина Паблишер, 2018.- 198 с.

- 10. Soroush Vosoughi, Deb Roy, Sinan Aral. The spread of true and false news online [Recurso electrónico]: Science / Soroush Vosoughi, Deb Roy, Sinan Aral. - 2018. - Vol. 359. - Issue 6380.- 1146-1151.-https://science.sciencemag.org/content/359/6380/1146.full

- 11. Архипова А. Можно ли победить фейкньюс законом [Электронный ресурс] / А. Архипова А. Кирзюк // Ведомости. – 2019. - 10 марта. - https://www.vedomosti.ru/opinion/articles/2019/03/10/796034-mozhno-pobedit-zakonom

- 12. Цукерберг стал выделять фэйковые новости в Facebook специальной меткой [Электронный ресурс] // Блог PR-CY. – http://pr-cy.ru/news/p/6119

- 13. Новак Т. Фейковые новости о выборах в США оказались популярнее реальных [Электронный ресурс] / Т. Новак. – https://apparat.cc/news/buzzfeed-viral-fake-election-news/

- 14. How to spot fake news and how to stop it from spreading [Recurso electrónico]. - http://6abc.com/news/fake-news-is-dominating-facebook/1621221/

- 15. Kimberly Powell. Researchers Showcase Major Advances in Deep Learning at NIPS [Recurso electrónico]: NVIDIA 2017 December 3 / Kimberly Powell. - https://blogs.nvidia.com/blog/2017/12/03/nvidia-research-nips/

- 16. Samantha Cole. AI-Assisted Fake Porn Is Here and We’re All Fucked [Recurso electrónico]: 2017 December 11 / Samantha Cole. - https://www.vice.com/en_us/article/gydydm/gal-gadot-fake-ai-porn

- 17. К чему привело повальное увлечение порно с голливудскими звездами [Электронный ресурс].–https://lenta.ru/articles/2018/02/09/deepfake/

- 18. Sue Curry Jansen, Brian Martin The Streisand effect and censorship backfire // International Journal of Communication. - - Vol. 9. - pp. 656—671.

- 19. James Vincent. Watch Jordan Peele use AI to make Barack Obama deliver a PSA about fake news [Recurso electrónico]: 2018 Apr 1 / James Vincent. - https://www.theverge.com/tldr/2018/4/17/17247334/ai-fake-news-video-barack-obama-jordan-peele-buzzfeed

- 20. Вы не поверите, что Обама говорит на этом видео! Дипфейк Видео [Электронный ресурс].–https://youtu.be/cQ54GDm1eL0

- 21. «Дипфейк» – информационное оружие будущего [Электронный ресурс].– https://ru.krymr.com/a/29347608.html

- 22. https://www.defenseone.com/technology/2019/03/next-phase-ai-deep-faking-whole-world-and-china-ahead/155944/

- 23. Кадочникова С. «Настали опасные времена». Захват власти и новая мировая война: как хакеры за год стали еще опаснее [Электронный ресурс] / С. Кадочникова.– https://lenta.ru/articles/2020/01/01/cybercrime2020

- 24. Дипфейки станут неотличимы от оригиналов в течение 6-12 месяцев [Электронный ресурс].– https://hightech.plus/2019/09/24/dipfeiki-stanut-neotlichimi-ot-originalov-v-techenie-6-12-mesyacev

- 25. Kevin Stankiewicz. ‘Perfectly real’ deepfakes will arrive in 6 months to a year, technology pioneer Hao Li says [Recurso electrónico]: - SEP 20 / Kevin Stankiewicz. – https://www.cnbc.com/2019/09/20/hao-li-perfectly-real-deepfakes-will-arrive-in-6-months-to-a-year.html

- 26. Мун, Д.В. От «Титаника» до «Зимней вишни». Алгоритмы грядущих катастроф : 3-е изд., доп. и перераб. – Москва ; Берлин : Директ-Медиа, 2018. – 352 с. ISBN 978-5-4475-9669-9

- 27. Eva Hambach. Time to midnight on the doomsday clock for the entire history of the project [Recurso electrónico]. - https://www.npr.org

- 28. David Welna. The End May Be Nearer: Doomsday Clock Moves Within 100 Seconds Of Midnight [Recurso electrónico]: 2020 January 23 / David Welna. - https://www.npr.org/2020/01/23/799047659/the-end-may-be-nearer-doomsday-clock-moves-within-100-seconds-of-midnight

- 29. Meng Jing. China issues new rules to clamp down on deepfake technologies used to create and broadcast fake news [Recurso electrónico]: South China Morning Post 2019 Nov 29 / Meng Jing. - https://www.scmp.com/tech/apps-social/article/3039978/china-issues-new-rules-clamp-down-deepfake-technologies-used

- 30. Michael Dimock. An update on our research into trust, facts and democracy [Recurso electrónico]: Pew Research Center 2019 JUNE 5 / Michael Dimock. - https://www.pewresearch.org/2019/06/05/an-update-on-our-research-into-trust-facts-and-democracy/

- 31. Лопатина Н.В. Современная информационная культура и информационные войны // Научно-техническая информация. Сер.1. – 2014. - №7. – С.1-4.

Сведения об авторах

Мун Дмитрий Вадимович, кандидат экономических наук, Заместитель Директора ФГБУ «Агентство «Эмерком» МЧС России, со-основатель международного экспертного сообщества «RISK.TODAY»,

Попета Владислав Владиславович, кандидат технических наук, основатель и президент международного экспертного сообщества «RISK.TODAY»

13.02.2020, 2009 просмотров.